座舱大模型为啥成了鸡肋?

超导、核聚变、量子计算和人工智能被誉为可以主宰人类文明走向的四大技术前沿。前三大技术目前基本上处于实验室预研阶段,人工智能则在这一二十的时间里得到了长足进步的发展。芯片方面,从可以做并行计算、擅长做乘加运算的GPU,到可以针对各类AI算子进行定向优化加速的NPU,到可以通过级联的方式形成大规模训练集群的高端训练芯片,算法方面,从可以提取图像特征的卷积神经网络到可进行时空对齐、初步具备上下文理解能力的Transformer,从各式各样的小模型到LLM大语言模型,各类创新层出不穷,不断推进着人工智能发展的无尽前沿。

当电动汽车走入智能化竞争的下半场,人工智能技术在汽车上的应用场景得到了大大拓展,最近这段时间最引人注目的进展有二。一个发生在智能驾驶领域,在特斯拉之后,蔚小理华们已经实质性地开启了向端到端智驾技术路线的切换,一众传统车企也在口头上实现了分段式端到端智驾方案。另外一个发生在智能座舱领域,大模型陆陆续续上车,问界、智界、享界车型接入华为的盘古大模型,极越、长安接入百度的文心一言大模型,腾势、江淮接入科大讯飞的星火大模型,以智能化技术见长的头部新势力车企蔚小理也纷纷上线了自研的GPT。

和各个车企在自动驾驶领域铺天盖地地宣传端到端形成鲜明对比的是,大家对座舱GPT的宣传都不咸不淡,以至于这些GPT没有引起太大的波澜,很快就归于沉寂了。何以然?原因很简单,端到端智驾不仅可以提高性能的天花板,还可以节省和钱相挂钩的算力资源,但现在的座舱大模型却处于一种比较尴尬的局面。

要明白大模型加持的座舱GPT怎么就成了食之无肉、弃之有味的鸡肋,只需要搞清楚三个问题:

● 现在的座舱GPT能干啥?

● 用户在期待啥?

● GPT为什么实现不了用户的期待?

1 座舱GPT能干啥?

目前,车企搬进智能座舱的GPT大模型主打功能有四:灌注了汽车知识的用车助手、压缩了文旅知识的出行助手、可查询影音知识的娱乐助手、可联网找答案的百科知识问答。乍看起来,这些车载GPT上知天文、下知地理,可以给被迫活到老、学到老的现代人提供专家系统支持,聊天机器人之前中看不中用,现在可以做到以自然语言的形式与用户进行沟通和交互,虽然很多时候也是牛头不对马嘴,让人产生“究竟是错付了”的荒诞感,但毕竟有了大幅度改观。

图片来源:江淮汽车

但是,在大多数可以在手机和PC端体验通义千问、文心一言、豆包、星火这些重量级大模型的消费者的眼中,这些座舱大模型并没有跨过“能用”到“好用”的边界。本质上,这些功能都是对用户需求的被动式回应。即便你能通过它的内容生成能力在车机大屏上画一个胸有成竹的男人,博君一笑之后静下心来想一想,又有什么意义呢?

图片来源:文心一言

说到根上,按照中国汽车工程协会的座舱智能等级划分标准,在没有接入车载GPT大模型之前,智能座舱毫无疑问地处于“L1感知智能座舱”阶段,但在接入形形色色的车载GPT之后,座舱的智能化等级依然没有进化到可以主动感知驾乘人员需求并主动执行任务的“L2部分认知智能座舱”阶段。抛开浮云遮望眼,这是各家车企上线座舱GPT之后用户体验没有出现断代式跨越的根本原因。

2 用户在期待什么?

人们把自动驾驶划分成5个等级,并将可以全面感知车辆周围环境、可在任何场景下执行驾驶任务的L5作为自动驾驶的终极目标。同样,如中国汽车工程协会制定的智能座舱智能化等级分类标准所示,人们对智能座舱的终极期待是它可以全场景主动感知用户的需求,并通过调用应用、服务、工具和系统设备,主动满足用户的需求。

图片来源:网络

现代社会,人们经常经历的委屈是“他不懂我”或者“他不给我”,简简单单两句诛心之语,背后涉及到理解需求和响应需求的能力。也许他是个榆木脑袋,对需求理解不够,或者信奉罗老师那种“彪悍的人生不需要解释”的生存哲学,不具备同理心,做不到“懂你 ”;又或许是他响应需求的能力不足,他不是不知道你的委屈,但是,搬起砖就没法空出手来抱你,拥你入怀就无法搬砖,确实无法“给你”。

再返回用户期待智能座舱发挥的价值,主动感知用户需求对应的是理解能力-“我懂你”,自主执行任务对应的是生成能力-“我给你”,用户对智能座舱的期待就是“我懂你”、“我给你”!

3 座舱GPT为何不能满足用户期待?

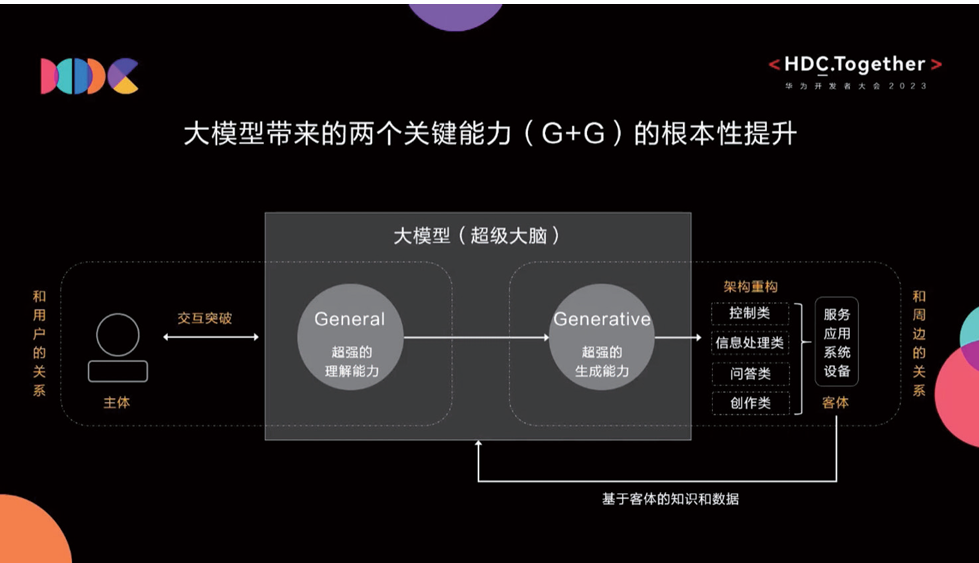

理论上来讲,大模型带来了理解和生成两个关键能力的根本性提升,似乎可以满足用户对智能座舱的期待,但实际表现却并非如此。是因为大语言模型的底层架构不合适?还是因为车企们没有发挥出大模型的潜力?

图片来源:华为

都不是。智能系统(包括手机、平板等智能终端和智能座舱、自动驾驶系统等)的理解能力和生成能力虽然是对人机交互至关重要的两种能力,但是,大模型的理解能力带来的人机交互方式的突破并不足以建立对用户需求的真正理解能力。

因为,这种理解能力虽然可以将目前的单模态感知升级为触控、语音、视觉信息相融合的多模态感知,但也仅此而已,它只能捕捉很短一段时间内用户的手势、眼神、声音、按键和触控动作,它所建立的连续时空认知对于一个活了半辈子的人来说太短了!我们一路走来,穿越人生的风雨,内心早已千疮百孔,座舱大模型如果不能通过一次又一次记忆并分析用户的数据,慢慢走近用户的内心,它怎么和用户真正地共情,给出的反应又怎么可能真正符合用户的心思?

也就是说,智能座舱必须具备情感引擎,学习、分析用户的数据,树立跟该用户一致的人生观、价值观和世界观,建立起在这个不太温暖的人类社会中有些缺乏的共情能力,才能严丝合缝地给出用户想要的输出或反馈,实现有温度的情感陪伴。

图片来源:蔚来汽车

要做到这一点,或许需要大模型底层技术继续进化,真正产生意识并发展出类人的情感,这样或许可以降低对学习用户数据的需求。如果在当前的技术架构上做情感引擎,出于对个人隐私的保护,数据不能出车,大模型不能在云端训练,如果在车端训练,以车端推理芯片做模型训练,这种方式不大常见,应该非常难。

4 写在最后

倘若座舱大模型真能大幅度改善消费者与汽车之间的交互,影响用户的生活和人生体验,想必大家伙儿不至于把它晾在一边。但是,对于一项新技术,既不要高估它的短期表现,也不要忽略它的长期进展。正如ChatGPT、GPT-4、GPT-4o,上下文从32K提高到了128K,从只接受文本发展到可以接受图像和照片在内的多模态输入,每一次版本的更新都会带来能力的进步,座舱大模型的未来也是可以期待的!

(本文登于EEPW 2024年9月期)

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码

相关文章

-

-

-

-

-

-

-

2024-09-26

-