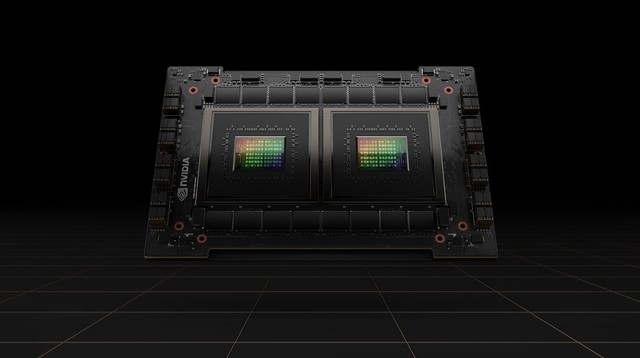

英伟达H100具有800亿晶体管首次使用HBM3

Nvidia在其年度GTC会议上宣布了一系列以AI为重点的企业产品。其中包括其新的硅架构Hopper的细节;第一个使用该架构的数据中心GPU H100;一个新的Grace CPU "超级芯片";以及该公司声称将建立世界上最快的AI超级计算机的模糊计划,名为Eos。

Nvidia从过去十年的人工智能热潮中受益匪浅,其GPU被证明是流行的、数据密集型深度学习方法的完美匹配。Nvidia表示,随着AI领域对数据计算需求的增长,它希望提供更多的火力。

特别是,该公司强调了一种被称为变形金刚的机器学习系统的普及。这种方法已经取得了令人难以置信的成果,为从OpenAI的GPT-3等语言模型到DeepMind的AlphaFold等医疗系统提供动力。在几年的时间里,此类模型的规模呈指数级增长。例如,当OpenAI在2019年推出GPT-2时,它包含15亿个参数(或连接)。当谷歌在两年后训练一个类似的模型时,它使用了1.6万亿个参数。

随着AI要求更多的计算机,Nvidia希望提供它

"训练这些巨型模型仍然需要几个月的时间,"Nvidia产品管理高级总监Paresh Kharya在一次新闻发布会上说。"所以你解雇了一个工作,并等待一个半月,看看会发生什么。缩短这个训练时间的一个关键挑战是,随着你在数据中心增加GPU的数量,性能收益开始下降。"

Nvidia表示,其新的Hopper架构将有助于改善这些困难。该架构以先驱计算机科学家和美国海军少将Grace Hopper的名字命名,与上一代芯片相比,该架构专门用于在H100 GPU上加速变形金刚模型的训练,而新的第四代Nivida NVlink可以连接多达256个H100 GPU,带宽比上一代高9倍。

H100 GPU本身包含800亿个晶体管,是第一个支持PCle Gen5和利用HBM3的GPU,使内存带宽达到3TB/s。Nvidia表示,H100 GPU在FP16、FP32和FP64计算方面比其上一代A100快三倍,在8位浮点数学方面快六倍。

"对于巨型变形金刚模型的训练,H100将提供高达9倍的性能,在几天内完成过去需要几周的训练,"Kharya说。

该公司还宣布了一个新的数据中心CPU--Grace CPU超级芯片,它由两个CPU组成,通过一个新的低延迟NVLink-C2C直接连接。该芯片旨在与新的基于Hopper的GPU一起 "服务于巨型HPC和AI应用",并可用于纯CPU系统或GPU加速的服务器。它有144个Arm核心和1TB/s的内存带宽。

新的格雷斯CPU "超级芯片 "由两个CPU连接而成。

除了硬件和基础设施新闻,Nvidia还宣布了其各种企业人工智能软件服务的更新,包括Maxine(提供音频和视频增强功能的SDK,旨在为虚拟化身等提供动力)和Riva(用于语音识别和文本转语音的SDK)。

该公司还预告说,它正在建造一台新的人工智能超级计算机,它声称在部署时将是世界上最快的。这台名为Eos的超级计算机将采用Hopper架构,包含约4600个H100 GPU,提供18.4 exaflops的 "AI性能"。该系统将只用于Nvidia的内部研究,该公司表示它将在几个月后上线。

在过去几年中,一些对人工智能有浓厚兴趣的公司已经建立或宣布了他们自己的内部 "人工智能超级计算机",用于内部研究,包括微软、特斯拉和Meta。这些系统与普通的超级计算机没有直接的可比性,因为它们的运行精度较低,这使得一些公司能够通过宣布世界上最快的超级计算机而迅速地相互跨越。

然而,在他的主题演讲中,Nvidia首席执行官黄仁勋确实表示,Eos在运行传统的超级计算机任务时,将架设275 petaFLOPS的计算量--比 "美国最快的科学计算机"(Summit)快1.4倍。"我们期望Eos成为世界上最快的人工智能计算机,"黄说。"Eos将成为我们的OEM和云合作伙伴最先进的AI基础设施的蓝图"。

加入微信

获取电子行业最新资讯

搜索微信公众号:EEPW

或用微信扫描左侧二维码